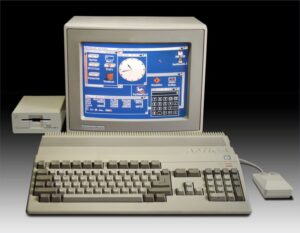

Ist es wirklich notwendig, über den Amiga 500 zu schreiben? Über einen Computer, den viele als ihren ersten „echten“ Rechner erlebt haben, über den sich Mythen ranken, dessen Name noch heute nostalgische Reflexe auslöst? Vielleicht ist es genau deshalb notwendig. Denn der Amiga 500 war nicht nur ein Erfolgsmodell, sondern ein kulturelles Phänomen – eines, dessen Bedeutung sich erst im Rückblick vollständig erschließt. Wir sprechen von einem Computer, der millionenfach verkauft wurde, der Generationen prägte und dennoch wirtschaftlich nie jene Stabilität erreichte, die sein Einfluss vermuten ließe. Zeit also, den Amiga 500 in Ruhe einzuordnen. Der Amiga 500 war weniger Neuentwicklung als bewusste Neupositionierung.

Ist es wirklich notwendig, über den Amiga 500 zu schreiben? Über einen Computer, den viele als ihren ersten „echten“ Rechner erlebt haben, über den sich Mythen ranken, dessen Name noch heute nostalgische Reflexe auslöst? Vielleicht ist es genau deshalb notwendig. Denn der Amiga 500 war nicht nur ein Erfolgsmodell, sondern ein kulturelles Phänomen – eines, dessen Bedeutung sich erst im Rückblick vollständig erschließt. Wir sprechen von einem Computer, der millionenfach verkauft wurde, der Generationen prägte und dennoch wirtschaftlich nie jene Stabilität erreichte, die sein Einfluss vermuten ließe. Zeit also, den Amiga 500 in Ruhe einzuordnen. Der Amiga 500 war weniger Neuentwicklung als bewusste Neupositionierung.

Nachdem der technisch revolutionäre, aber teure Amiga 1000 den Markt kaum erreichte, wurde bei Commodore früh klar, dass die Zukunft der Plattform nicht in einem weiteren Prestigeobjekt lag, sondern in einem erschwinglichen, massentauglichen System. Ziel war es, die außergewöhnlichen Fähigkeiten der Amiga-Architektur in ein kompaktes Gerät zu überführen, das näher an der Lebensrealität der Nutzer lag. Der Amiga 500 sollte kein Demonstrator sein, sondern ein Alltagsrechner – wohnzimmertauglich, preislich erreichbar und vielseitig einsetzbar. Diese Pragmatik war kein Rückschritt, sondern Voraussetzung des Erfolgs.

Dabei spiegelte sich auch eine unterschiedliche Entwicklungsphilosophie innerhalb des Commodore-Konzerns wider. Beide Modelle wurden bei Commodore in West Chester entwickelt, verfolgten jedoch von Beginn an unterschiedliche Zielsetzungen. Während der Amiga 500 konsequent auf den Heim- und Massenmarkt ausgerichtet war, wurde der Amiga 2000 auf eine modularere, professionell erweiterbare Nutzung hin konzipiert. Anforderungen aus dem internationalen Umfeld – insbesondere aus Europa – beeinflussten dabei vor allem die Auslegung des Amiga 2000, etwa im Hinblick auf Steckplätze, Videoanbindung. Dort standen Erweiterbarkeit, Steckplätze, Videoanwendungen und Studioeinsätze im Vordergrund. Beide Modelle nutzten dieselbe Grundarchitektur, verkörperten jedoch unterschiedliche Antworten auf dieselbe Frage: Was sollte ein Amiga sein? Der Amiga 500 beantwortete sie aus Sicht des Heimcomputers, der Amiga 2000 aus Sicht der Workstation.

Technisch basierte der Amiga 500 auf derselben grundlegenden Architektur wie der zuvor erschienene Amiga 1000. Herzstück war der Motorola 68000, intern mit rund 7,14 MHz im NTSC- und etwa 7,09 MHz im PAL-Betrieb getaktet. Für sich genommen war dieser Prozessor kein Hochleistungswunder, doch das Zusammenspiel mit den spezialisierten Custom-Chips machte den Unterschied. Agnus übernahm Speicherverwaltung und DMA-Zugriffe, Denise war für die Grafik zuständig, Paula kümmerte sich um Audio, Diskettensteuerung und Interrupts. Ergänzt wurde dieses Trio durch Gary, der Bus-Logik und zentrale Teile der Adressdekodierung kontrollierte.

Diese Aufgabenteilung erlaubte es dem Amiga, viele audiovisuelle Prozesse parallel zur CPU auszuführen – ein Ansatz, der ihn im Heimcomputerbereich der Mitte der 1980er-Jahre durch die Kombination aus Grafik-, Sound- und Multitasking-Fähigkeiten deutlich von zeitgenössischen Systemen abhob.

Diese Architektur zahlte sich besonders in der Praxis aus. Während zeitgenössische Rechner viele Aufgaben vollständig der CPU überließen, konnte der Amiga Grafik- und Soundoperationen auslagern, ohne den Hauptprozessor zu blockieren. Das Ergebnis war eine Leistungsfähigkeit, die sich unmittelbar in Spielen, Demos und Multimedia-Anwendungen zeigte. Grafikmodi mit bis zu 4096 Farben (HAM), vier unabhängige 8-Bit-Audiokanäle und echtes präemptives Multitasking waren im Heimcomputerbereich Mitte der 1980er-Jahre nahezu konkurrenzlos.

Zwar beruhte auch der Amiga 1000 auf derselben Architektur, erwies sich im Auslieferungszustand jedoch als deutlich unpraktischer im Alltag. Da das Kickstart noch nicht im ROM vorlag, musste das Betriebssystem beim Start von Diskette in den Arbeitsspeicher geladen werden, wodurch ein erheblicher Teil der ursprünglich nur 256 KB RAM bereits belegt war, bevor Anwendungen oder Spiele überhaupt beginnen konnten. Technisch war der Amiga 1000 keineswegs eingeschränkt – mit Speichererweiterungen ließ er sich leistungsfähig ausbauen –, doch erst der Amiga 500 beseitigte diese Einstiegshürden konsequent und machte die Architektur im Serienzustand wirklich alltagstauglich.

Mit dem A500 wanderte Kickstart fest ins ROM. Der Rechner war nach dem Einschalten sofort funktionsfähig – kürzere Bootzeiten, höhere Robustheit, geringere Einstiegshürden. Der Preis: Updates erforderten ROM-Tausch.

Während der Amiga 1000 sein Betriebssystem bei jedem Start von Diskette laden musste, stand dem Amiga 500 nach dem Einschalten sofort eine lauffähige Systembasis zur Verfügung. Das verkürzte Startzeiten, erhöhte die Zuverlässigkeit und senkte die Einstiegshürde erheblich. Diese Entscheidung war jedoch nicht unumstritten. Teile des Entwicklerumfelds sahen im festgeschriebenen Kickstart-ROM eine Einschränkung, da frühe Designentscheidungen damit schwerer korrigierbar wurden und Weiterentwicklungen einen physischen Austausch des ROMs erforderten. Was für den Alltag ein Gewinn war, konnte langfristig zur Fixierung werden – ein klassischer Zielkonflikt zwischen Benutzerfreundlichkeit und technischer Flexibilität.

Auf Kickstart aufbauend stellte die Workbench die grafische Arbeitsumgebung des Amiga dar. Sie folgte bewusst nicht der damals verbreiteten Desktop-Metapher, sondern setzte auf eigene Begriffe und Konzepte. Verzeichnisse hießen „Drawer“, Programme „Tools“, Dateien „Projects“. Parallel dazu existierte mit der CLI von Beginn an eine vollwertige Kommandozeile, die nicht als Notlösung, sondern als gleichberechtigter Zugang zum System gedacht war. Der Amiga war nie ein reines GUI-System, sondern ein Rechner, der grafische und textbasierte Arbeitsweisen selbstverständlich miteinander verband. Besonders bemerkenswert war, dass das Betriebssystem bereits früh präemptives Multitasking bot – nicht als Demonstration, sondern als Alltagsfunktion, selbst auf Systemen mit begrenztem Speicher.

Ein zentrales Merkmal der Amiga-Architektur war das differenzierte Speicherkonzept. Chip-RAM bildete den gemeinsamen Arbeitsbereich von CPU und Custom-Chips und war essenziell für Grafik und Sound. Slow-RAM, häufig über den Trapdoor-Slot unter der Gehäuseklappe realisiert, konnte zwar von der CPU genutzt werden, lief jedoch über den Chip-Bus und unterlag dessen Busarbitration, wodurch der Zugriff langsamer war als auf echtes Fast-RAM. Erst mit späteren Agnus-Revisionen oder beim Amiga 500 Plus ließ sich dieser Speicher direkt als Chip-RAM einbinden. Fast-RAM schließlich war ausschließlich der CPU vorbehalten und deutlich effizienter, da es nicht am Chip-Bus hing und somit keine Wartezyklen durch den Chipsatz entstehen konnten. Im Amiga 500 wurde solches Fast-RAM vor allem über den seitlichen Expansionsport realisiert.

Vereinfacht lässt sich das so verstehen: Chip-RAM ist eine Hauptverkehrsstraße, auf der sich CPU, Grafik und Sound den Zugriff teilen. Slow-RAM ist eine Nebenstraße mit Wartezeiten. Fast-RAM hingegen ist eine exklusive Schnellstraße nur für die CPU. Für Spiele war Chip-RAM entscheidend, für Anwendungen Fast-RAM – ein Spannungsfeld, das den Ausbau des Amiga 500 prägte.

Frühe A500 mit dem Agnus 8370/8371 boten 512 KB Chip (plus 512 KB Slow über Trapdoor). Spätere Revisionen erhöhten auf 1 MB Chip; mit dem 8375 konnten in entsprechend bestückten Systemen bis 2 MB Chip genutzt werden (z. B. A500 Plus).

Ergänzend dazu konnten über den seitlichen Expansionsport mehrere Megabyte Fast-RAM nachgerüstet werden – in der Praxis meist bis zu acht Megabyte –, während zusätzliches Slow-RAM in bestimmten Konfigurationen ebenfalls genutzt werden konnte.

In der Alltagspraxis blieben solche Maximalbestückungen jedoch die Ausnahme. Die meisten Anwender begnügten sich mit moderaten Speichererweiterungen und investierten eher in Komfortzubehör wie Festplattenlösungen. Turbokarten mit 68020- oder 68030-Prozessoren existierten zwar bereits, waren jedoch teuer, nicht immer vollständig kompatibel und boten für viele Spiele kaum einen spürbaren Vorteil. Der typische Amiga-500-Nutzer investierte daher weniger in rohe Rechenleistung als in Speicher und Bedienkomfort. Genau hier zeigte sich, wo die Erweiterbarkeit des Amiga 500 an ihre Grenzen stieß. Mehr Speicher machte das System angenehmer, aber nicht grundlegend moderner. Die CPU und der Chipsatz blieben unverändert, während sich der PC-Markt über stetige Prozessor-Upgrades weiterentwickelte. Der Amiga 500 ließ sich optimieren, aber nicht beliebig weiterdenken. Erweiterbarkeit wurde zur Feinarbeit, nicht mehr zur Zukunftsperspektive.

Mit seiner Markteinführung 1987 traf der Amiga 500 auf einen Markt im Umbruch. In Großbritannien hatte sich der ZX Spectrum etabliert, in Deutschland war der Commodore 64 allgegenwärtig. Der A500 trat nicht an, um diese Systeme direkt zu ersetzen, sondern um sie abzulösen. Besonders in Europa wurde er rasch als der „neue C64“ wahrgenommen – leistungsfähiger, moderner, aber ähnlich zugänglich. Diese Rolle als natürlicher Nachfolger des klassischen Heimcomputers erwies sich als außerordentlich erfolgreich.

In Deutschland entwickelte sich der Amiga 500 zur dominierenden Heimcomputerplattform der späten 1980er-Jahre. Er fand seinen Weg in Kinder- und Jugendzimmer, in Wohngemeinschaften und Hobbykeller. Spiele wie Shadow of the Beast, Turrican, Speedball 2 oder The Secret of Monkey Island zeigten eindrucksvoll, wozu die Maschine fähig war. Action-, Sport- und Arcade-Titel dominierten dabei zahlenmäßig den Markt, während Adventures vor allem kulturell und erzählerisch prägend waren.

Bemerkenswert war, dass der Amiga 500 nicht nur Spieler ansprach. Er wurde zugleich zum kreativen Werkzeug für Musik, Grafik, Textverarbeitung und Programmierung. Programme wie Deluxe Paint oder ProTracker machten ihn zur Produktionsplattform. Diese Offenheit war gewollt – und sie hatte Konsequenzen. Die einfache Kopierbarkeit von Disketten, das Fehlen wirksamer Schutzmechanismen und eine schnell wachsende Cracker-Szene führten dazu, dass Softwareverkäufe oft weit hinter der tatsächlichen Nutzung zurückblieben.

Aus diesem Umfeld entwickelte sich auch die legendäre Demoszene. Was als technische Spielerei begann, wuchs zu einer eigenständigen Kunstform heran, in der Gruppen nicht um Verkaufszahlen konkurrierten, sondern um Effizienz, Kreativität und das Ausloten technischer Grenzen. Der Amiga 500 wurde zur Bühne für audiovisuelle Experimente, deren Einfluss bis heute spürbar ist. Die wirtschaftlichen Folgen für Softwarehersteller resultierten dabei jedoch weniger aus der Demoszene selbst als aus dem weiteren Umfeld der Cracker-Szene, aus dem viele Gruppen hervorgingen und das insgesamt ein Klima schuf, in dem Software vielfach unentgeltlich verbreitet wurde.

Für Commodore selbst war der Erfolg des Amiga 500 ein zweischneidiges Schwert. Der Rechner verkaufte sich hervorragend, doch das Unternehmen verdiente fast ausschließlich an der Hardware. Anders als Konsolenhersteller verfügte Commodore über kein geschlossenes Lizenzsystem, das kontinuierliche Einnahmen aus Software generiert hätte. Die aggressive Preispolitik sicherte Marktanteile, reduzierte jedoch die Margen. Der Amiga 500 hielt Commodore am Leben, stabilisierte das Unternehmen jedoch nicht nachhaltig.

International zeigte sich ein deutliches Gefälle. Während der Amiga in Europa kulturell dominierte, blieb er in den USA ein Nischenprodukt. Dort setzten sich IBM-kompatible PCs zunehmend durch, getragen von Standardisierung, beruflicher Nutzung und klaren Upgrade-Pfaden. Der Amiga gewann Herzen, aber keine Märkte. Diese Diskrepanz zwischen kultureller Bedeutung und wirtschaftlicher Realität wurde im Laufe der Jahre immer deutlicher.

Ein entscheidender Faktor für diese Entwicklung lag außerhalb der reinen Technik. Der Amiga setzte sich nie als Büro- oder Unternehmensstandard durch. Dafür fehlte ihm weniger Leistungsfähigkeit als vielmehr eine zwingende Anwendung – eine sogenannte Killer-App. Während andere Systeme durch einzelne Programme quasi institutionalisiert wurden, blieb der Amiga in dieser Hinsicht fragmentiert. Der IBM-PC etablierte sich im Geschäftsalltag nicht primär wegen einer technischen Überlegenheit im Heimcomputer-Sinn, sondern weil Anwendungen wie Tabellenkalkulationen, Textverarbeitung und Datenbanken dort früh zu De-facto-Standards wurden. Wer im Büro arbeitete, arbeitete mit diesen Programmen – und damit zwangsläufig mit der zugrunde liegenden Plattform.

Auf dem Amiga existierten zwar leistungsfähige Alternativen, doch keine davon erreichte eine vergleichbare Marktdominanz oder institutionelle Verbindlichkeit. Selbst spezialisierte Erfolge wie Cinema 4D blieben auf klar umrissene Zielgruppen beschränkt und eigneten sich nicht als Fundament für eine allgemeine Büro-IT. Hinzu kam, dass Microsoft als zentraler Softwarelieferant kein strategisches Interesse daran hatte, eine konkurrierende Plattform zu stärken, während man parallel das eigene Betriebssystem-Ökosystem für den IBM-PC aufbaute. Der Amiga blieb dadurch ein freier, kreativer Rechner – aber ohne die softwareseitige Verankerung, die für eine nachhaltige Präsenz in Büros, Verwaltungen und Unternehmen notwendig gewesen wäre.

Wie sich diese wachsende Diskrepanz zwischen technischer Leistungsfähigkeit, kultureller Bedeutung und fehlender institutioneller Verankerung entwickelte, lässt sich gut an der zeitgenössischen Fachpresse ablesen. Magazine wie Power Play begleiteten den Amiga 500 über Jahre hinweg und stellten ihn regelmäßig in Vergleichsübersichten neuen Systemen gegenüber. Anfang der 1990er-Jahre veränderte sich der Tonfall spürbar. Der Amiga 500 wurde zunehmend als etablierter Klassiker betrachtet, dessen Stärken bekannt, dessen Grenzen aber ebenso offensichtlich geworden waren. Dieser Wandel erfolgte nicht abrupt, sondern schleichend – und gerade darin lag seine Aussagekraft.

Auch auf Hardware-Ebene spiegelte sich die besondere Entwicklerkultur wider. Auf mehreren Mainboard-Revisionen des Amiga 500 findet sich der interne Codename „Rock Lobster“ beziehungsweise „B52“ direkt auf der Leiterplatte aufgedruckt – eine Referenz an den gleichnamigen Song der B-52’s. Solche Codenamen waren Ausdruck einer informellen, kreativen Ingenieurskultur, wie sie für das Amiga-Team typisch war.

Ein weiteres stilles Detail dieser Kultur findet sich in der Workbench selbst. Das Uhr-Icon, das ab späteren Versionen verwendet wurde, zeigt eine Zeigerstellung, die in der Amiga-Community häufig als stilles Gedenken an die Challenger-Katastrophe von 1986 interpretiert wird. Dabei handelt es sich um eine verbreitete, jedoch nicht belegte Deutung, für die es keine offizielle Bestätigung gibt. Gleichwohl fügt sie sich stimmig in den zeitgeschichtlichen Kontext einer Ära ein, in der Raumfahrt, Technikoptimismus und Computerentwicklung eng miteinander verknüpft waren. Bleibt die Frage der historischen Einordnung: War der Amiga 500 noch ein Homecomputer? Nach klassischer Definition ja: ein erschwinglicher Rechner für den privaten Gebrauch, mit integrierter Tastatur, offen für Spiel, Lernen und Kreativität. War er der letzte seiner Art? Nicht absolut. Systeme wie der Atari ST oder spätere Amiga-Modelle existierten parallel. Doch der Amiga 500 markiert einen Endpunkt – einen der letzten Heimcomputer, der diese Rolle kulturell, technisch und wirtschaftlich vollständig ausfüllte, bevor sich der Markt endgültig auf PC und Konsole aufteilte.

Gerade darin liegt seine historische Bedeutung. Der Amiga 500 war kein perfektes System, aber ein offenes. Er ermöglichte eine Form von Computerkultur, die Experiment, Spiel, Kreativität und Gemeinschaft miteinander verband. Dass er wirtschaftlich nicht dauerhaft bestehen konnte, schmälert diesen Einfluss nicht – es erklärt ihn. Der Amiga 500 war ein Rechner seiner Zeit, und zugleich einer, der ihr in vielerlei Hinsicht voraus war.

Als der NCR Personal Computer Model 4 Mitte der 1980er Jahre erschien, stand dahinter kein Newcomer, sondern eines der traditionsreichsten Unternehmen der Datenverarbeitung. NCR – ursprünglich National Cash Register – war bereits seit dem späten 19. Jahrhundert im Bereich mechanischer und später elektronischer Rechen- und Kassensysteme aktiv und hatte sich im Laufe des 20. Jahrhunderts zu einem globalen Anbieter von Banktechnik, Transaktionssystemen und Großrechner-Peripherie entwickelt. Lange bevor der Personal Computer den Büromarkt eroberte, prägten NCR-Systeme bereits den Alltag von Banken, Verwaltungen und Handelsketten. Der Einstieg in den PC-Markt war daher weniger ein Experiment als der Versuch, diese gewachsene Erfahrung in eine neue Geräteklasse zu übertragen.

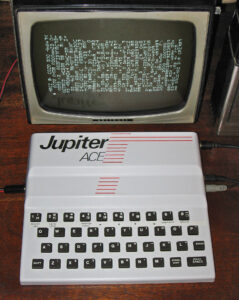

Als der NCR Personal Computer Model 4 Mitte der 1980er Jahre erschien, stand dahinter kein Newcomer, sondern eines der traditionsreichsten Unternehmen der Datenverarbeitung. NCR – ursprünglich National Cash Register – war bereits seit dem späten 19. Jahrhundert im Bereich mechanischer und später elektronischer Rechen- und Kassensysteme aktiv und hatte sich im Laufe des 20. Jahrhunderts zu einem globalen Anbieter von Banktechnik, Transaktionssystemen und Großrechner-Peripherie entwickelt. Lange bevor der Personal Computer den Büromarkt eroberte, prägten NCR-Systeme bereits den Alltag von Banken, Verwaltungen und Handelsketten. Der Einstieg in den PC-Markt war daher weniger ein Experiment als der Versuch, diese gewachsene Erfahrung in eine neue Geräteklasse zu übertragen. Als der Jupiter Ace im Herbst 1982 erschien, war er zugleich ein Produkt seiner Zeit und ein bewusster Gegenentwurf zu ihr. Entwickelt wurde der Rechner von Richard Altwasser und Steven Vickers, zwei Ingenieuren, die zuvor maßgeblich für Sinclair Research gearbeitet hatten. Altwasser war bereits an der Entwicklung des

Als der Jupiter Ace im Herbst 1982 erschien, war er zugleich ein Produkt seiner Zeit und ein bewusster Gegenentwurf zu ihr. Entwickelt wurde der Rechner von Richard Altwasser und Steven Vickers, zwei Ingenieuren, die zuvor maßgeblich für Sinclair Research gearbeitet hatten. Altwasser war bereits an der Entwicklung des

Als Atari Anfang der achtziger Jahre noch immer vom Erfolg des Atari 2600 lebte, hatte sich die Welt der Videospiele bereits spürbar verändert. Das VCS hatte eine ganze Generation geprägt, Wohnzimmer erobert und das Medium Heimvideospiel überhaupt erst gesellschaftsfähig gemacht. Doch der anhaltende Erfolg hatte auch träge gemacht. Technische Entscheidungen wurden verschleppt, der Markt unterschätzt, und mit dem Atari 5200 brachte das Unternehmen schließlich ein System auf den Markt, das zwar leistungsfähiger war, sich jedoch konzeptionell gegen seinen eigenen Vorgänger stellte. Fehlende Abwärtskompatibilität, ein unglücklicher Controller und eine unklare Positionierung sorgten dafür, dass Atari erstmals ernsthaft an Bindung und Vertrauen verlor – ein Warnsignal, das intern zu spät erkannt wurde.

Als Atari Anfang der achtziger Jahre noch immer vom Erfolg des Atari 2600 lebte, hatte sich die Welt der Videospiele bereits spürbar verändert. Das VCS hatte eine ganze Generation geprägt, Wohnzimmer erobert und das Medium Heimvideospiel überhaupt erst gesellschaftsfähig gemacht. Doch der anhaltende Erfolg hatte auch träge gemacht. Technische Entscheidungen wurden verschleppt, der Markt unterschätzt, und mit dem Atari 5200 brachte das Unternehmen schließlich ein System auf den Markt, das zwar leistungsfähiger war, sich jedoch konzeptionell gegen seinen eigenen Vorgänger stellte. Fehlende Abwärtskompatibilität, ein unglücklicher Controller und eine unklare Positionierung sorgten dafür, dass Atari erstmals ernsthaft an Bindung und Vertrauen verlor – ein Warnsignal, das intern zu spät erkannt wurde. Der ZPA IQ-151 gehört zu den markantesten Bildungscomputern des sozialistischen Ostblocks, ein Rechner, der weniger durch technische Brillanz als durch seine Entstehungsbedingungen und seine Rolle im tschechoslowakischen Schulsystem in Erinnerung geblieben ist. Entwickelt und produziert wurde er ab 1985 vom Betrieb ZPA Nový Bor, einem Unternehmen, das ursprünglich auf Mess- und Automatisierungstechnik spezialisiert war. Der IQ-151 war dabei nie als klassischer Heimcomputer gedacht; er wurde überwiegend an Schulen und Bildungseinrichtungen ausgegeben, die in den 1980er-Jahren erstmals systematisch mit Informatikunterricht experimentierten. Seinen Namen erhielt der Rechner von der eingesetzten CPU, der Tesla MHB8080A, einem lokalen Nachbau des Intel-8080-Prozessors, der mit 2 MHz lief und dem Gerät eine für Bildungszwecke ausreichende, wenn auch bescheidene Rechenleistung verlieh.

Der ZPA IQ-151 gehört zu den markantesten Bildungscomputern des sozialistischen Ostblocks, ein Rechner, der weniger durch technische Brillanz als durch seine Entstehungsbedingungen und seine Rolle im tschechoslowakischen Schulsystem in Erinnerung geblieben ist. Entwickelt und produziert wurde er ab 1985 vom Betrieb ZPA Nový Bor, einem Unternehmen, das ursprünglich auf Mess- und Automatisierungstechnik spezialisiert war. Der IQ-151 war dabei nie als klassischer Heimcomputer gedacht; er wurde überwiegend an Schulen und Bildungseinrichtungen ausgegeben, die in den 1980er-Jahren erstmals systematisch mit Informatikunterricht experimentierten. Seinen Namen erhielt der Rechner von der eingesetzten CPU, der Tesla MHB8080A, einem lokalen Nachbau des Intel-8080-Prozessors, der mit 2 MHz lief und dem Gerät eine für Bildungszwecke ausreichende, wenn auch bescheidene Rechenleistung verlieh.

Wenn man alten Spielhallenstaub abklopft, findet man manchmal Geräte, bei denen man sich fragt, ob sie wirklich zum Spielen gedacht waren oder ob da jemand einfach zu lange an einer Platine geschnüffelt hat. Atari Touch Me gehört definitiv in diese Kategorie. Vier Knöpfe, vier Töne, ein kleiner Digitalzähler und keinerlei Grafik. Atari selbst nannte das 1974 ernsthaft „TOUCH ME – A MIND BOGGLER!“ („Touch Me – ein Gehirnverdreher!“). Wir nennen es: das wahrscheinlich minimalistischste Gedächtnistraining der Arcade-Geschichte.

Wenn man alten Spielhallenstaub abklopft, findet man manchmal Geräte, bei denen man sich fragt, ob sie wirklich zum Spielen gedacht waren oder ob da jemand einfach zu lange an einer Platine geschnüffelt hat. Atari Touch Me gehört definitiv in diese Kategorie. Vier Knöpfe, vier Töne, ein kleiner Digitalzähler und keinerlei Grafik. Atari selbst nannte das 1974 ernsthaft „TOUCH ME – A MIND BOGGLER!“ („Touch Me – ein Gehirnverdreher!“). Wir nennen es: das wahrscheinlich minimalistischste Gedächtnistraining der Arcade-Geschichte. Was folgte, ist Spielzeuggeschichte. Baer und Howard Morrison nahmen das Grundprinzip, polierten es auf und entwickelten 1978 Simon – ja, das Simon, mit den vier farbigen Feldern, harmonischen Tönen und dem legendären „Fang den Rhythmus“-Gefühl. Simon wurde ein riesiger Erfolg, in zeitgenössischen Rückblicken sogar als „one of the top-selling toys“ („eines der meistverkauften Spielzeuge“) bezeichnet. Kinderzimmer weltweit hatten plötzlich eine elektronische Wundertrommel, die Tonfolgen auswarf, und Atari stand ein bisschen so da, als hätte man das Originalrezept erfunden, aber jemand anderes den Kuchen gebacken – und dafür den Preis bekommen.

Was folgte, ist Spielzeuggeschichte. Baer und Howard Morrison nahmen das Grundprinzip, polierten es auf und entwickelten 1978 Simon – ja, das Simon, mit den vier farbigen Feldern, harmonischen Tönen und dem legendären „Fang den Rhythmus“-Gefühl. Simon wurde ein riesiger Erfolg, in zeitgenössischen Rückblicken sogar als „one of the top-selling toys“ („eines der meistverkauften Spielzeuge“) bezeichnet. Kinderzimmer weltweit hatten plötzlich eine elektronische Wundertrommel, die Tonfolgen auswarf, und Atari stand ein bisschen so da, als hätte man das Originalrezept erfunden, aber jemand anderes den Kuchen gebacken – und dafür den Preis bekommen. Atari versuchte später, mit einem Handheld nachzuziehen. Das Ding hieß BH-100, lief mit einer 9-Volt-Batterie und sah aus wie die Kreuzung aus Taschenrechner und Frühzeit-Elektronikspiel. Mehrere Spielmodi, vier Schwierigkeitsstufen, Farben, Töne – alles solide, aber nicht annähernd so elegant wie das runde Simon-Design. Wer eines der Geräte heute auf dem Flohmarkt findet, kann sich glücklich schätzen – nicht wegen des Spielspaßes, sondern wegen der Seltenheit.

Atari versuchte später, mit einem Handheld nachzuziehen. Das Ding hieß BH-100, lief mit einer 9-Volt-Batterie und sah aus wie die Kreuzung aus Taschenrechner und Frühzeit-Elektronikspiel. Mehrere Spielmodi, vier Schwierigkeitsstufen, Farben, Töne – alles solide, aber nicht annähernd so elegant wie das runde Simon-Design. Wer eines der Geräte heute auf dem Flohmarkt findet, kann sich glücklich schätzen – nicht wegen des Spielspaßes, sondern wegen der Seltenheit.